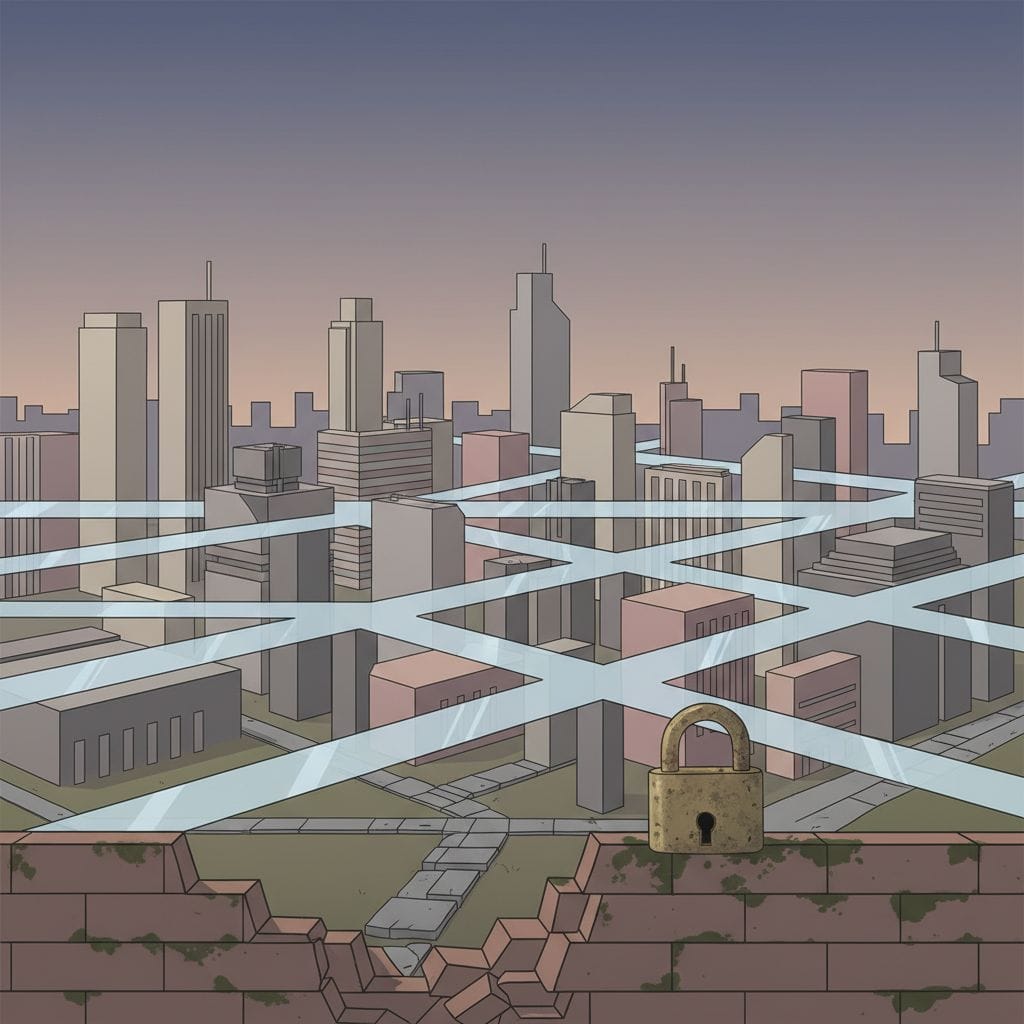

Firmy enterprise coraz częściej stawiają na federacyjne podejście do AI, łącząc wiele technologii oraz modeli. Te zmiany idą jednak w parze z nowym typem ryzyka: bezpieczeństwem i niejasnością związaną z przepływem danych pomiędzy skomplikowanymi ekosystemami. Moja teza jest prosta — kierunek AI w dużych organizacjach nie polega już na pojedynczych, spektakularnych algorytmach, lecz na tworzeniu złożonych, fabrykowych środowisk, gdzie głównym wyzwaniem staje się nie efektywność, a zarządzanie zależnością i bezpieczeństwem danych.

Federacyjne AI: szansa czy iluzja kontroli?

Pojawienie się federacyjnych modeli AI na poziomie przedsiębiorstw to próba uniezależnienia się od dostawców technologii i globalnych monopoli. Fabryki AI powstają po to, by samodzielnie budować i utrzymywać ekosystemy rozwiązań, które lepiej odpowiadają potrzebom konkretnej firmy. Wielomodelowe platformy dają elastyczność oraz potencjalnie korzystniejsze ceny. Jednak ta sama różnorodność modeli niesie ze sobą poważne wyzwania.

Zwiększanie liczby „komponentów” wymaga skomplikowanego zarządzania zależnościami. Prawdziwe znaczenie tego trendu polega na próbie przejęcia kontroli nad strategicznymi aktywami: danymi i kompetencjami analitycznymi. Ale iluzja pełnej niezależności może być zwodnicza. Im więcej modeli i integracji, tym więcej „węzłów”, w których dane mogą wyciekać lub być narażone na manipulacje. Otwarty charakter części rozwiązań, np. modele open-weight, dodatkowo potęguje zagrożenia, ponieważ trudniej wymusić spójność i egzekwować jednolite polityki ochrony.

Czego nie wiemy: fragmentacja i nowe ryzyka bezpieczeństwa

Chociaż dużo mówi się o efektywności federacyjnych podejść, część kluczowych kwestii pozostaje wciąż niejasna. Nie mamy dostatecznych badań na temat:

- wpływu integracji wielu modeli na spójność i ciągłość danych,

- kosztów zarządzania rozproszonymi zależnościami między różnymi platformami,

- ryzyka fragmentacji, która może utrudnić śledzenie, gdzie i jak te same dane są przetwarzane.

Zamiast skupiać się wyłącznie na pozytywach i uproszczonej narracji — „więcej modeli to większa kontrola” — warto pamiętać, że multi-modelowe ekosystemy mogą prowadzić do powstania nowych, trudniej wykrywalnych podatności. Pojawia się pytanie, czy organizacje są gotowe nie tylko inwestować w takie rozwiązania, ale też ponosić odpowiedzialność za coraz bardziej złożony krajobraz zagrożeń.

Federacyjne podejścia, choć mają sens w kontekście wyścigu technologicznego i walki z uzależnieniem od globalnych platform, generują wyzwania na poziomie bezpieczeństwa, które będą narastać. Zachęcam do dalszego zgłębiania tej tematyki na https://sztucznainteligencjablog.pl/ — bo prawdziwe konsekwencje nowych trendów AI dopiero się wyłaniają.