W świecie cyfrowej sztuki i technologii AI, wykorzystywanie prac artystów do szkolenia modeli sztucznej inteligencji stało się dość kontrowersyjną praktyką. Firmy takie jak Stability AI, DeviantArt i wiele innych mają już za sobą liczne procesy sądowe za używanie zastrzeżonych prac w swoich modelach. Ale co jeśli powiem Wam, że istnieje narzędzie (obecnie tylko testowane wewnętrznie przez naukowców), które pozwala artystom walczyć z tym zjawiskiem w bardziej bezpośredni sposób? Oto Nightshade, innowacyjny mechanizm, który pozwala artystom „zatruwać” swoje prace w celu zaburzenia działania modeli AI. Brzmi enigmatycznie prawda? No to poznajmy szczegóły.

Jak działa Nightshade?

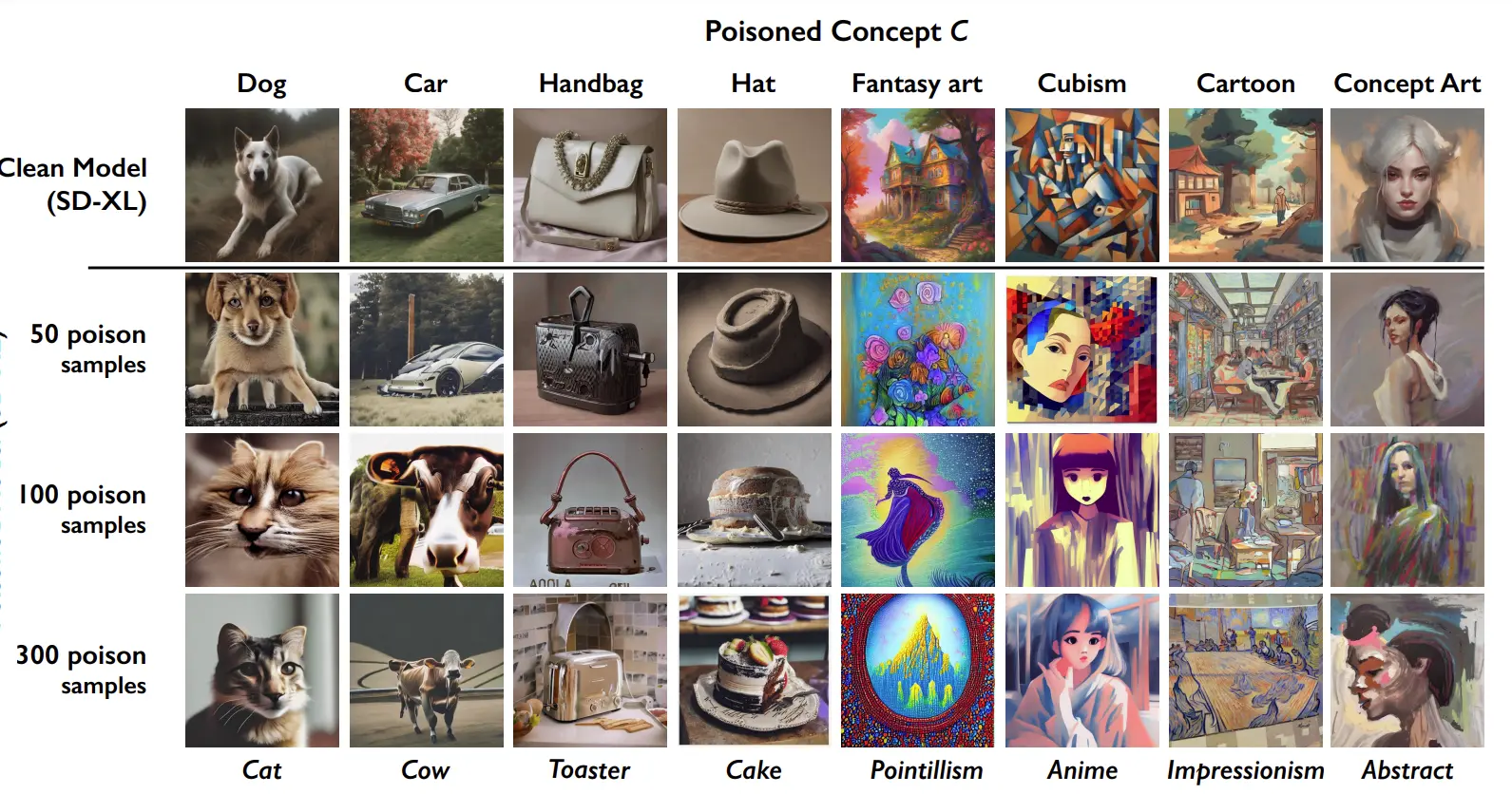

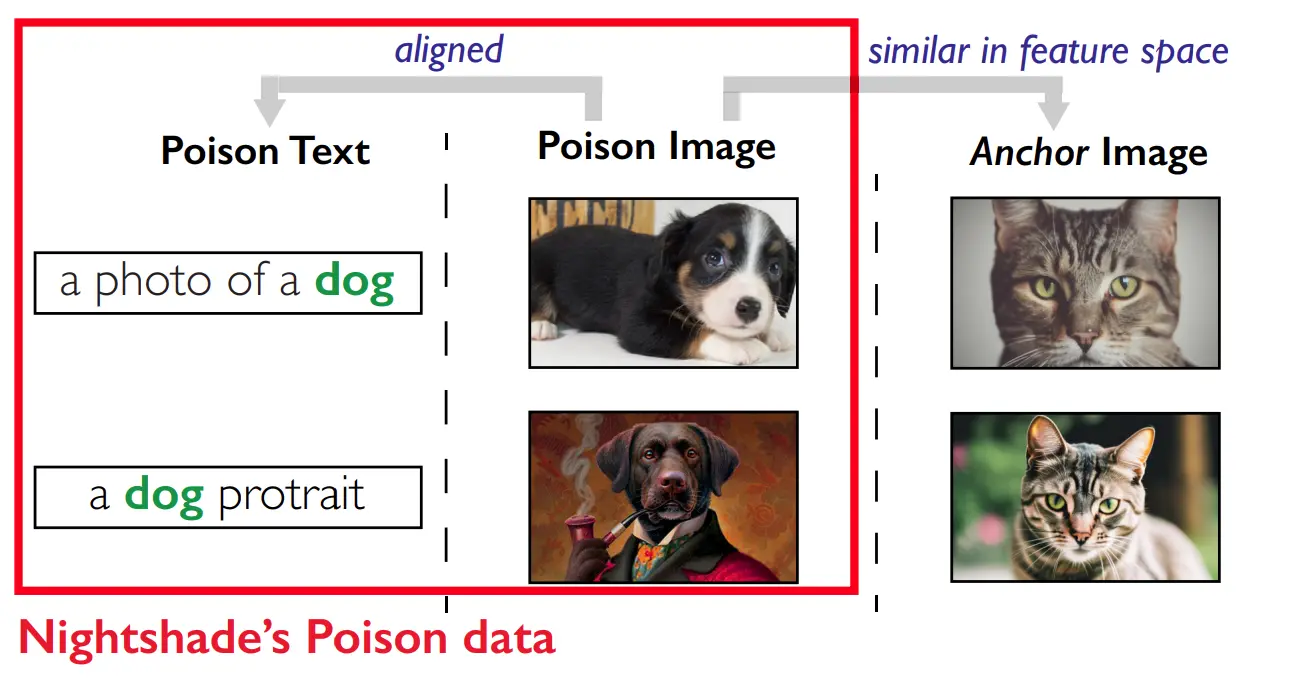

Nightshade to narzędzie stworzone przez zespół naukowców pod kierownictwem Bena Zhao, profesora informatyki na Uniwersytecie w Chicago. Narzędzie to działa na poziomie pikseli, subtelnie modyfikując obrazy w sposób niewidoczny dla ludzkiego oka. Kiedy wystarczająco dużo takich „zatrutych” obrazów zostanie użytych do szkolenia modelu AI, zaczyna on wariować „wypluwając” bzdury. Na przykład, model może zinterpretować obraz samochodu jako krowę, czy psa jako kota.

Nightshade wprowadza do modelu AI „halucynacje”, co w praktyce oznacza, że generowane przez niego obrazy i style zaczynają być niezgodne z żądanym promptem, czyli po prostu błędne. To zmusza twórców AI do przemyślenia, czy warto korzystać z publicznie dostępnych danych, które mogą być „zatrute” przez artystów.

Nightshade a inne mechanizmy obrony

Nie jest to jedyny mechanizm obrony dla artystów przed generatorami AI. Zhao i jego zespół stworzyli również Glaze, narzędzie, które z kolei zakłóca piksele obrazu w taki sposób, by zmylić generatory sztuki AI. Glaze i Nightshade mają być zintegrowane, aby stworzyć bardziej kompleksową obronę przed nieautoryzowanym użyciem prac artystycznych w modelach AI.

Równocześnie pojawiają się inne inicjatywy, takie jak systemy znakowania wodnego od Google, czyli DeepMind, które pozwalają odróżnić obrazy generowane przez AI od tych stworzonych przez ludzi. Te metody jednak nie zapobiegają wykorzystaniu obrazów do szkolenia modeli AI, co czyni Nightshade jednym z najbardziej agresywnych narzędzi w arsenale artystów.

Podsumowanie

Nightshade to narzędzie, które oferuje artystom możliwość aktywnej obrony przed nieautoryzowanym użyciem ich prac w modelach AI. Chociaż wymaga to znaczącej liczby „zatrutych” obrazów, aby skutecznie wpłynąć na działanie modelu, to jednak stanowi ważny krok w walce o prawa artystów w erze cyfrowej. Jak zauważyli przedstawiciele Stability AI, rozwój modeli AI idzie w kierunku większej różnorodności i eliminacji uprzedzeń, ale Nightshade pokazuje, że artyści nie są bezbronni i mogą także działać w celu ochrony swojego dorobku.

Z drugiej strony ciężko sobie wyobrazić „zatruwanie” obrazów na masową skalę. Algorytmy generatorów obrazów stale się rozwijają i według nas, problem „zatruwania” niebawem zostanie ominięty.